Warning: file_exists(): open_basedir restriction in effect. File(//www.intoep.com/wp-content/uploads/2025/02/c62d1ecfcde145d39083d0f634268386_tplv-tt-origin-web_gif.jpeg) is not within the allowed path(s): (/www/wwwroot/www.intoep.com/:/tmp/) in /www/wwwroot/www.intoep.com/wp-content/plugins/image-converter-webp/inc/Core/Converter.php on line 92

Warning: file_exists(): open_basedir restriction in effect. File(//www.intoep.com/wp-content/uploads/2025/02/c62d1ecfcde145d39083d0f634268386_tplv-tt-origin-web_gif.jpeg) is not within the allowed path(s): (/www/wwwroot/www.intoep.com/:/tmp/) in /www/wwwroot/www.intoep.com/wp-content/plugins/image-converter-webp/inc/Core/Converter.php on line 92

Warning: file_exists(): open_basedir restriction in effect. File(//www.intoep.com/wp-content/uploads/2025/02/c62d1ecfcde145d39083d0f634268386_tplv-tt-origin-web_gif.jpeg) is not within the allowed path(s): (/www/wwwroot/www.intoep.com/:/tmp/) in /www/wwwroot/www.intoep.com/wp-content/plugins/image-converter-webp/inc/Core/Converter.php on line 92

Warning: file_exists(): open_basedir restriction in effect. File(//www.intoep.com/wp-content/uploads/2025/02/c62d1ecfcde145d39083d0f634268386_tplv-tt-origin-web_gif.jpeg) is not within the allowed path(s): (/www/wwwroot/www.intoep.com/:/tmp/) in /www/wwwroot/www.intoep.com/wp-content/plugins/image-converter-webp/inc/Core/Converter.php on line 92

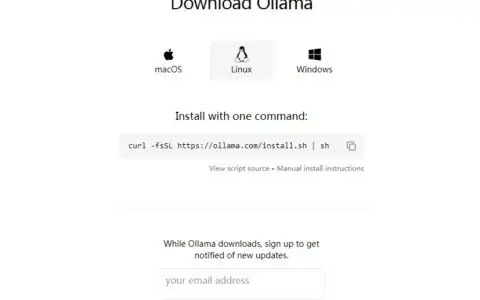

Ollama下载

https://ollama.com/download/windows

Windows 安装

如果直接双击 OllamaSetup.exe 安装,默认会安装到 C 盘,如果需要指定安装目录,需要通过命令行指定安装地址,如下:

# 切换到安装目录

C:\Users\lisiyu>D:

# 执行安装

D:\ollama>OllamaSetup.exe /DIR="d:\ollama\"- Windows指定路径安装 > OllamaSetup.exe /DIR=E:\SDK\Ollama

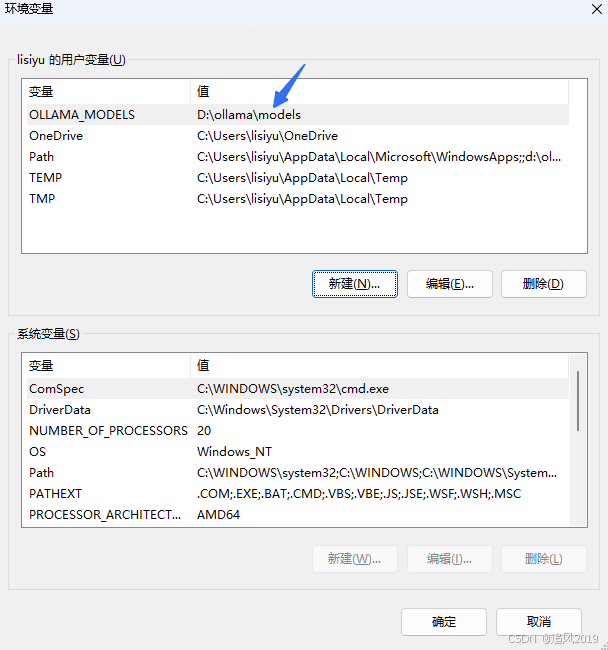

设置模型存储路径

要更改 Ollama 存储下载模型的位置,而不是使用你的主目录,可以在你的用户账户中设置环境变量 OLLAMA_MODELS。

如下,先在安装 ollama 目录下创建 models 文件夹,然后在 windows 下设置环境变量:

快捷使用

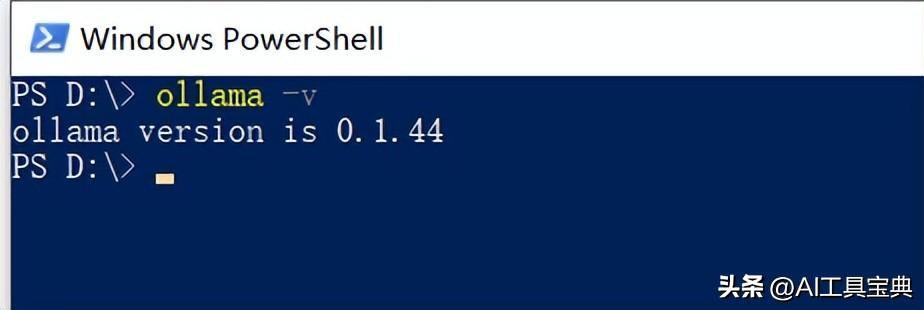

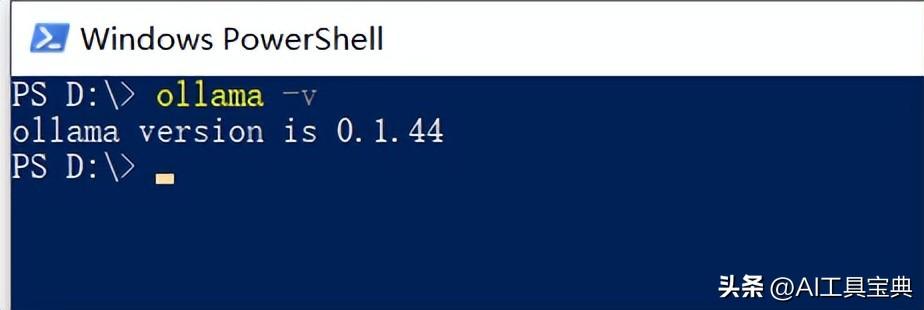

- 查看 ollama 版本

C:\Users\lisiyu>ollama --version

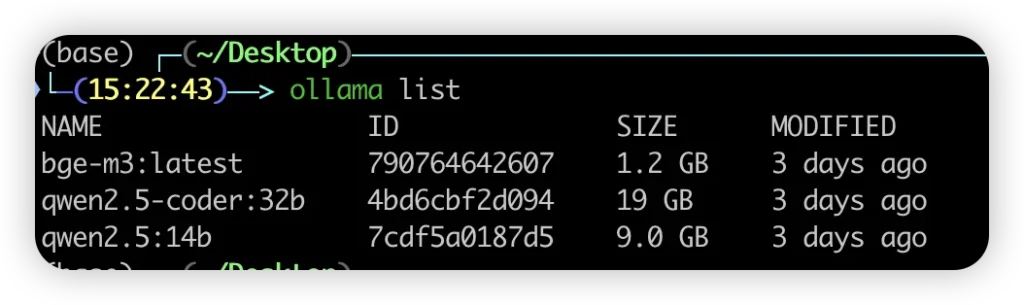

ollama version is 0.5.7- 查看 ollama 已下载模型列表

C:\Users\lisiyu>ollama list

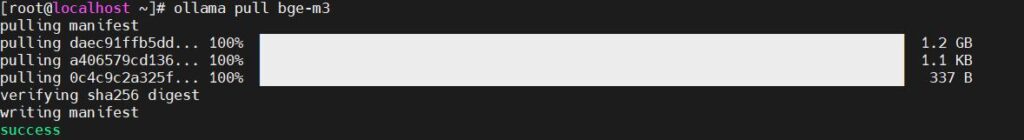

NAME ID SIZE MODIFIED- 拉取模型

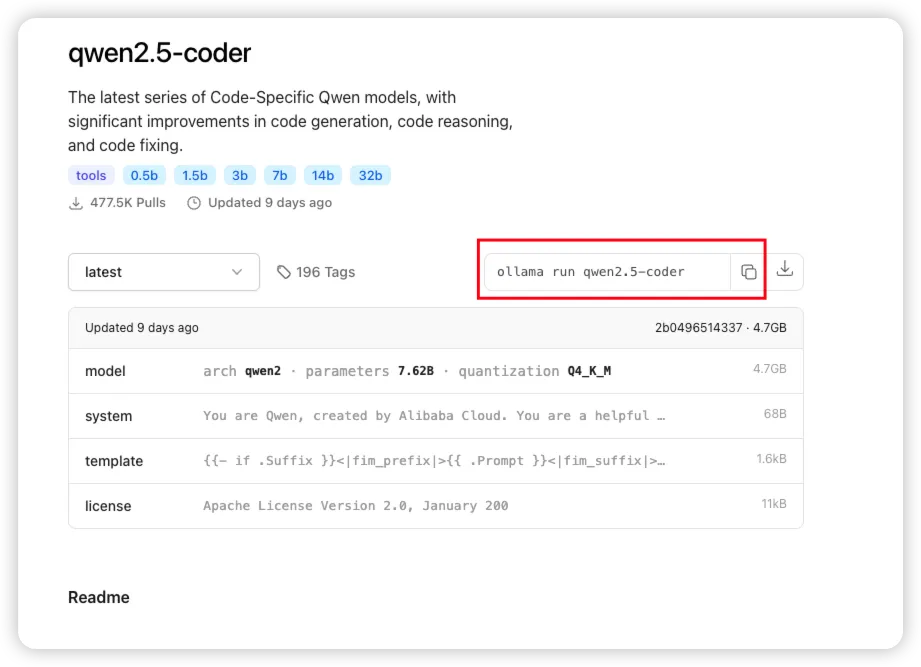

查看模型列表:https://ollama.com/search

PS C:\Users\lisiyu\Desktop> ollama pull deepseek-r1:8b

pulling manifest

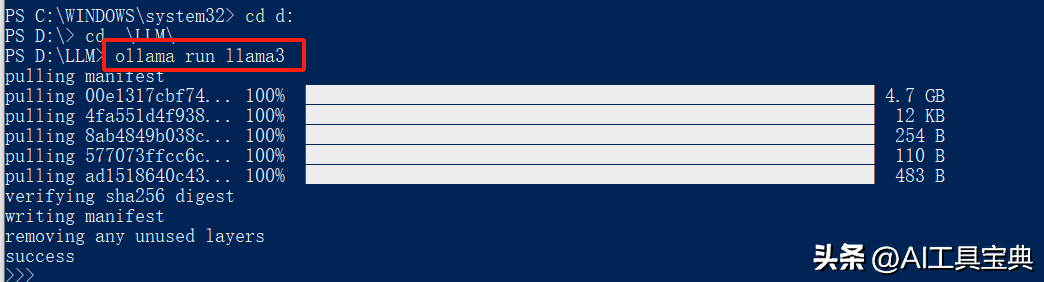

pulling 6340dc3229b0... 26% ▕█████████████████████████████ ▏ 1.3 GB/4.9 GB 3.5 MB/s 17m32s - 运行模型(如果模型未拉取,默认会先执行 pull 拉取)

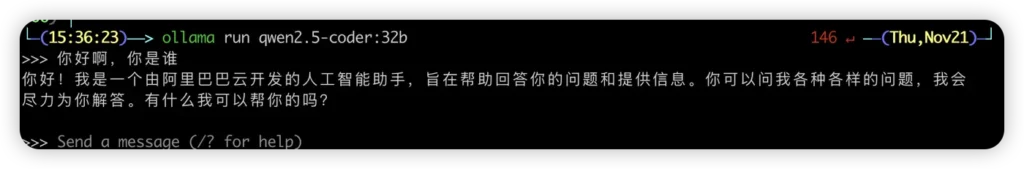

C:\Users\lisiyu>ollama run deepseek-r1:8b

>>> Send a message (/? for help)

# 此时进入对话窗口

# 如果要退出,输入 /bye 执行退出

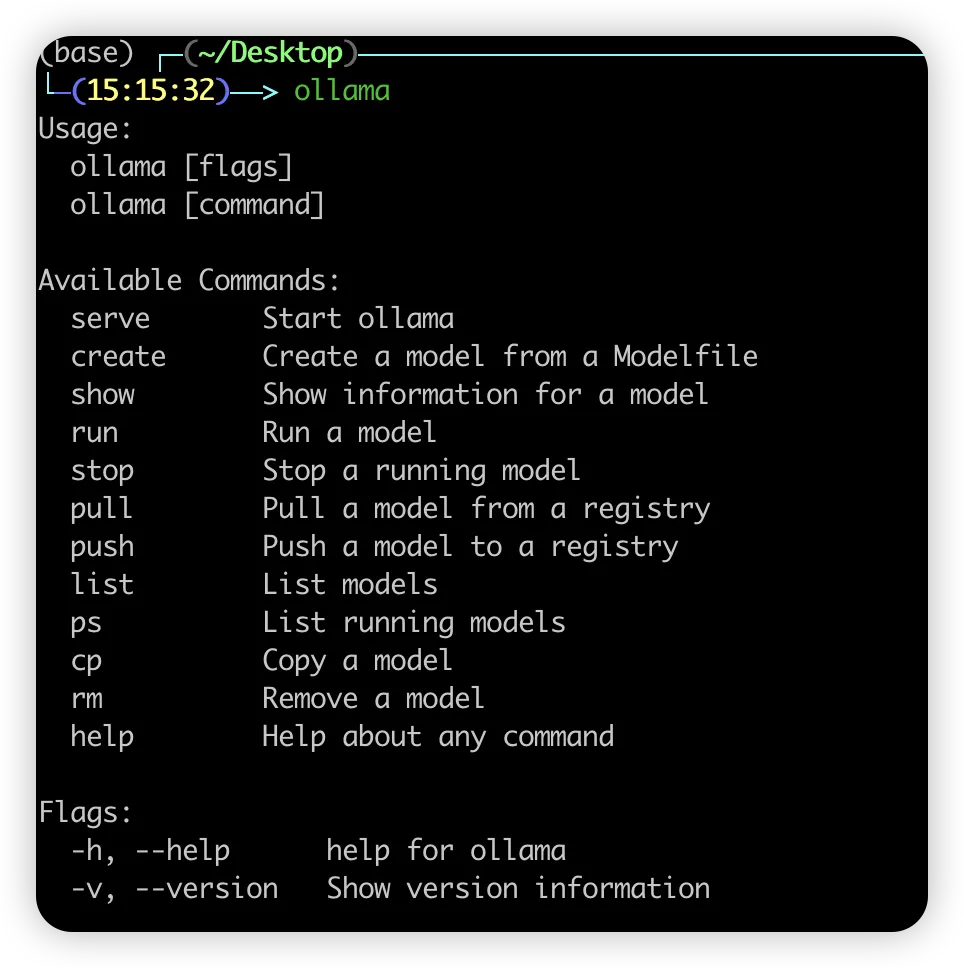

# 退出后,ollama 也会在后台运行- 更多命令,参考帮助说明:

C:\Users\lisiyu>ollama help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.Ollama API

- 默认访问地址:https://localhost:11434 或者 https://127.0.0.1:11434

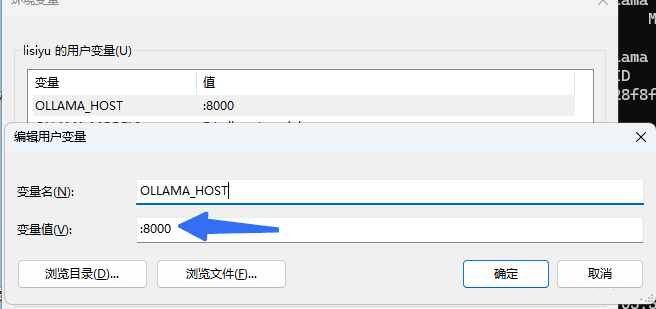

- 允许外网访问:

由于默认只能在本机访问,所以,要允许外网访问,要监听 0.0.0.0 地址。

且有些场景需要指定端口。

此时可以通过设置环境变量 OLLAMA_HOST 来定义,如下:

- Ollama 支持的 API:

| API URL | 请求方式 | 请求参数 | 响应参数 | API 说明 | CURL 请求示例 |

|---|---|---|---|---|---|

/api/generate | POST | model(模型名称)、prompt(提示文本)、可选参数(如 stream、suffix 等) | response(生成的文本)、tokens(生成的 token 数量)等 | 生成文本 | curl http://localhost:11434/api/generate -d '{"model": "llama2", "prompt": "为什么天空是蓝色的?"}' |

/api/chat | POST | model(模型名称)、messages(消息列表,包含角色和内容) | response(回复内容)、tokens(生成的 token 数量)等 | 聊天对话 | curl http://localhost:11434/api/chat -d '{"model": "llama2", "messages": [{"role": "user", "content": "你好!"}]}' |

/api/pull | POST | name(模型名称)、可选参数(如 insecure、stream 等) | 返回拉取进度或模型信息 | 拉取模型 | curl http://localhost:11434/api/pull -d '{"name": "llama2"}' |

/api/delete | DELETE | name(模型名称) | 返回状态码(200 OK 或 404 Not Found) | 删除模型 | curl -X DELETE http://localhost:11434/api/delete -d '{"name": "llama2"}' |

/api/tags | GET | 无 | 返回模型列表 | 获取本地模型列表 | curl http://localhost:11434/api/tags |

/api/show | POST | name(模型名称)、可选参数 verbose(是否返回详细信息) | 返回模型详细信息,包括 modelfile、parameters、template 等 | 查看模型信息 | curl http://localhost:11434/api/show -d '{"name": "llama2"}' |

/api/copy | POST | source(源模型名称)、destination(目标模型名称) | 返回状态码(200 OK 或 404 Not Found) | 复制模型 | curl http://localhost:11434/api/copy -d '{"source": "llama2", "destination": "llama2-backup"}' |

/api/create | POST | name(新模型名称)、modelfile(模型文件内容) | 返回创建状态或错误信息 | 创建自定义模型 | curl http://localhost:11434/api/create -d '{"name": "llama2-custom", "modelfile": "FROM llama2\nSYSTEM You are a helpful assistant."}' |

原创文章,作者:howkunet,如若转载,请注明出处:https://www.intoep.com/othen/65108.html

微信赞赏

微信赞赏  支付宝赞赏

支付宝赞赏